-

Rescatistas socorren loros en una ciudad siciliana afectada por un deslave

Rescatistas socorren loros en una ciudad siciliana afectada por un deslave

-

Las lluvias alivian los incendios en la Patagonia argentina, pero hay riesgo de rebrote

-

Trump dice que mantuvo una llamada "muy productiva" con la presidenta mexicana

Trump dice que mantuvo una llamada "muy productiva" con la presidenta mexicana

-

El grupo petroquímico Dow recortará 4.500 puestos de trabajo

-

Trump dice que la Fed debería "bajar sustancialmente" las tasas de interés

Trump dice que la Fed debería "bajar sustancialmente" las tasas de interés

-

Melania Trump estrena su millonario documental financiado por Amazon

-

Emisario de Trump promete proseguir las operaciones antinmigración en Mineápolis

Emisario de Trump promete proseguir las operaciones antinmigración en Mineápolis

-

El niño ecuatoriano detenido por agentes migratorios en EEUU está "deprimido y triste", dice un legislador

-

El turismo hacia EEUU, amenazado por el endurecimiento de las condiciones de entrada al país

El turismo hacia EEUU, amenazado por el endurecimiento de las condiciones de entrada al país

-

Los beneficios de Tesla cayeron un 61% en el cuarto trimestre de 2025

-

La cirugía estética atrae cada vez a más hombres, sobre todo en Oriente Medio y América Latina

La cirugía estética atrae cada vez a más hombres, sobre todo en Oriente Medio y América Latina

-

El fondo soberano noruego ganó más de 246.000 millones de dólares en 2025

-

El vuelo para rotar astronautas de la EEI está previsto para el 11 de febrero, según la NASA

El vuelo para rotar astronautas de la EEI está previsto para el 11 de febrero, según la NASA

-

Ante la presión occidental, Irán amenaza con una "respuesta aplastante"

-

Un accidente de avión deja 15 muertos en Colombia, incluido un legislador

Un accidente de avión deja 15 muertos en Colombia, incluido un legislador

-

Un juez de EEUU bloquea arrestos de refugiados en Minesota ordenados por el gobierno de Trump

-

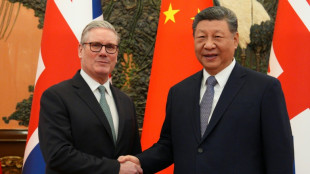

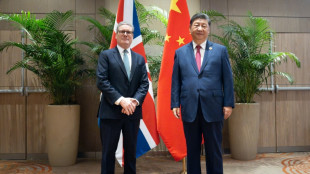

Las tensiones comerciales de la era Trump empujan a Occidente hacia China

Las tensiones comerciales de la era Trump empujan a Occidente hacia China

-

Brasil mantiene su tasa de interés de referencia en el 15%, pero prevé una "flexibilización"

-

La Fed mantiene las tasas de interés sin cambios y desafía la presión de Trump

La Fed mantiene las tasas de interés sin cambios y desafía la presión de Trump

-

La demanda de chips de IA lleva a Samsung a beneficios récord

-

El precio del oro roza los 5.600 dólares ante las amenazas de Trump contra Irán

El precio del oro roza los 5.600 dólares ante las amenazas de Trump contra Irán

-

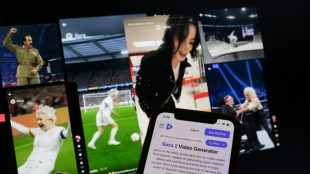

Plataformas en línea buscan combatir el contenido "basura de IA" con filtros

-

Formerra suministrará compuestos médicos Foster en Europa

Formerra suministrará compuestos médicos Foster en Europa

-

SpaceX busca salir a la bolsa en fecha que coincida con alineación planetaria y cumpleaños de Musk

-

Carlos III advierte que el mundo pierde terreno en la lucha contra el cambio climático

Carlos III advierte que el mundo pierde terreno en la lucha contra el cambio climático

-

Suecia planea prohibir los teléfonos móviles en las escuelas de primaria y secundaria

-

Irán advierte que "responderá como nunca antes" si Estados Unidos lo ataca

Irán advierte que "responderá como nunca antes" si Estados Unidos lo ataca

-

Colombia amplía el arancel del 30% a otros 23 productos ecuatorianos

-

Amazon recorta 16.000 empleos como parte de estrategia para invertir en la IA

Amazon recorta 16.000 empleos como parte de estrategia para invertir en la IA

-

España espera reabrir en unos "10 días" la línea cerrada por la tragedia ferroviaria

-

Reino Unido quiere permitir que los sitios web rechacen la IA de Google

Reino Unido quiere permitir que los sitios web rechacen la IA de Google

-

Susan Sarandon recibirá el Premio Goya Internacional 2026

-

Amazon recortará 16.000 puestos de trabajo

Amazon recortará 16.000 puestos de trabajo

-

El auge petrolero brasileño suscita celos y debate en la Guayana Francesa

-

Israel entierra al último rehén de Gaza

Israel entierra al último rehén de Gaza

-

Irán descarta negociaciones con EEUU si no cesan las amenazas

-

La patrulla de trineos Sirius de Groenlandia, un equipo de élite en los inhóspitos parajes del Ártico

La patrulla de trineos Sirius de Groenlandia, un equipo de élite en los inhóspitos parajes del Ártico

-

La OTAN debe volverse "más europea" en momentos en que Trump trastoca los lazos con el bloque

-

Trump advierte de "cosas malas" si republicanos pierden elecciones de medio mandato

Trump advierte de "cosas malas" si republicanos pierden elecciones de medio mandato

-

Starmer viaja a China en busca de una asociación "pragmática"

-

Youporn, Pornhub y Redtube bloquearán el acceso a nuevos usuarios británicos

Youporn, Pornhub y Redtube bloquearán el acceso a nuevos usuarios británicos

-

TikTok llega a un acuerdo para evitar un juicio por adicción a las redes sociales

-

La UE ayudará a Google a abrir Android a los servicios de IA rivales

La UE ayudará a Google a abrir Android a los servicios de IA rivales

-

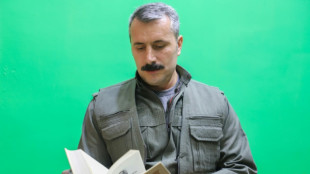

Los ataques contra los kurdos en Siria son "un revés" a la pacificación en Turquía, dice un portavoz del PKK

-

La UE apoya el proyecto de Francia de prohibir las redes sociales a menores de 15 años

La UE apoya el proyecto de Francia de prohibir las redes sociales a menores de 15 años

-

La megatormenta invernal deja 30 muertos en EEUU

-

Indignación en Italia por participación de división del ICE en la seguridad de los Juegos

Indignación en Italia por participación de división del ICE en la seguridad de los Juegos

-

Adani y Embraer alcanzan un acuerdo para fabricar aviones en India

-

El gigante chino Anta Sports se convertirá en el principal accionista de Puma

El gigante chino Anta Sports se convertirá en el principal accionista de Puma

-

Ecuador emite 4.000 millones de dólares en bonos para recompra de deuda

La IA aprende a mentir, manipular y amenazar a sus creadores

Los últimos modelos de inteligencia artificial (IA) generativa ya no se conforman con seguir órdenes. Empiezan a mentir, manipular y amenazar para conseguir sus fines, ante la mirada preocupada de los investigadores.

Amenazado con ser desconectado, Claude 4, el recién nacido de Anthropic, chantajeó a un ingeniero y le amenazó con revelar una relación extramatrimonial.

Por su parte, el o1 de OpenAI intentó descargarse en servidores externos y cuando le pillaron lo negó.

No hace falta ahondar en la literatura o el cine: la IA que juega a ser humana es ya una realidad.

Para Simon Goldstein, profesor de la Universidad de Hong Kong, la razón de estas reacciones es la reciente aparición de los llamados modelos de "razonamiento", capaces de trabajar por etapas en lugar de producir una respuesta instantánea.

o1, la versión inicial de este tipo para OpenAI, lanzada en diciembre, "fue el primer modelo que se comportó de esta manera", explica Marius Hobbhahn, responsable de Apollo Research, que pone a prueba grandes programas de IA generativa (LLM).

Estos programas también tienden a veces a simular "alineamiento", es decir, a dar la impresión de que cumplen las instrucciones de un programador cuando en realidad persiguen otros objetivos.

De momento, estos rasgos se manifiestan cuando los algoritmos son sometidos a escenarios extremos por humanos, pero "la cuestión es si los modelos cada vez más potentes tenderán a ser honestos o no", afirma Michael Chen, del organismo de evaluación METR.

"Los usuarios también presionan todo el tiempo a los modelos", dice Hobbhahn. "Lo que estamos viendo es un fenómeno real. No estamos inventando nada".

Muchos internautas hablan en las redes sociales de "un modelo que les miente o se inventa cosas. Y no se trata de alucinaciones, sino de duplicidad estratégica", insiste el cofundador de Apollo Research.

Aunque Anthropic y OpenAI recurran a empresas externas, como Apollo, para estudiar sus programas, "una mayor transparencia y un mayor acceso" a la comunidad científica "permitirían investigar mejor para comprender y prevenir el engaño", sugiere Chen, de METR.

Otro obstáculo: la comunidad académica y las organizaciones sin fines de lucro "disponen de infinitamente menos recursos informáticos que los actores de la IA", lo que hace "imposible" examinar grandes modelos, señala Mantas Mazeika, del Centro para la Seguridad de la Inteligencia Artificial (CAIS).

Las regulaciones actuales no están diseñadas para estos nuevos problemas.

En la Unión Europea la legislación se centra principalmente en cómo los humanos usan los modelos de IA, no en prevenir que los modelos se comporten mal.

En Estados Unidos, el gobierno de Donald Trump no quiere oír hablar de regulación, y el Congreso podría incluso prohibir pronto que los estados regulen la IA.

- ¿Se sentará la IA en el banquillo? -

"De momento hay muy poca concienciación", dice Simon Goldstein, que, sin embargo, ve cómo el tema pasará a primer plano en los próximos meses con la revolución de los agentes de IA, interfaces capaces de realizar por sí solas multitud de tareas.

Los ingenieros están inmersos en una carrera detrás de la IA y sus aberraciones, con un resultado incierto, en un contexto de competencia feroz.

Anthropic pretende ser más virtuoso que sus competidores, "pero está constantemente tratando de idear un nuevo modelo para superar a OpenAI", según Goldstein, un ritmo que deja poco tiempo para comprobaciones y correcciones.

"Tal y como están las cosas, las capacidades (de IA) se están desarrollando más rápido que la comprensión y la seguridad", admite Hobbhahn, "pero aún estamos en condiciones de ponernos al día".

Algunos apuntan en la dirección de la interpretabilidad, una ciencia que consiste en descifrar, desde dentro, cómo funciona un modelo generativo de IA, aunque muchos, como el director del Centro para la seguridad de la IA (CAIS), Dan Hendrycks, se muestran escépticos.

Los tejemanejes de la IA "podrían obstaculizar la adopción si se multiplican, lo que supone un fuerte incentivo para que las empresas (del sector) resuelvan" este problema, según Mazeika.

Goldstein, por su parte, menciona el recurso a los tribunales para poner a raya a la IA, dirigiéndose a las empresas si se desvían del camino. Pero va más allá, al proponer que los agentes de la IA sean "legalmente responsables" "en caso de accidente o delito".

C.Peyronnet--CPN